资源简介:

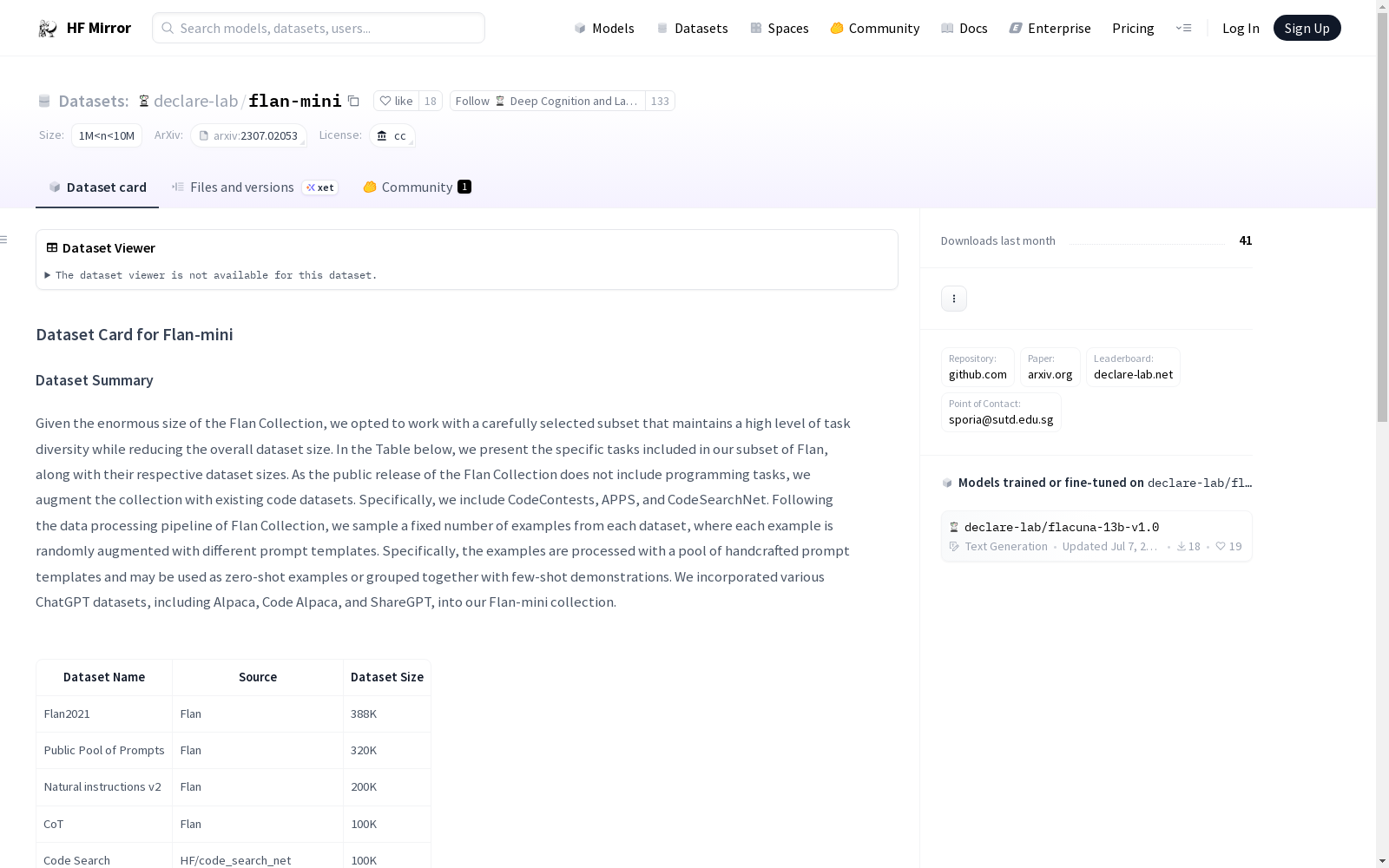

Flan-mini数据集是从Flan Collection中精心挑选的子集,旨在保持任务多样性的同时减少数据集的总大小。该数据集通过添加现有的代码数据集(如CodeContests、APPS和CodeSearchNet)进行了增强。数据集的每个样本都经过随机增强,使用了手工制作的提示模板,并可能作为零样本示例或与少量示例组合使用。此外,数据集还整合了多种ChatGPT数据集,包括Alpaca、Code Alpaca和ShareGPT。

原始地址:

https://hf-mirror.com/datasets/declare-lab/flan-mini