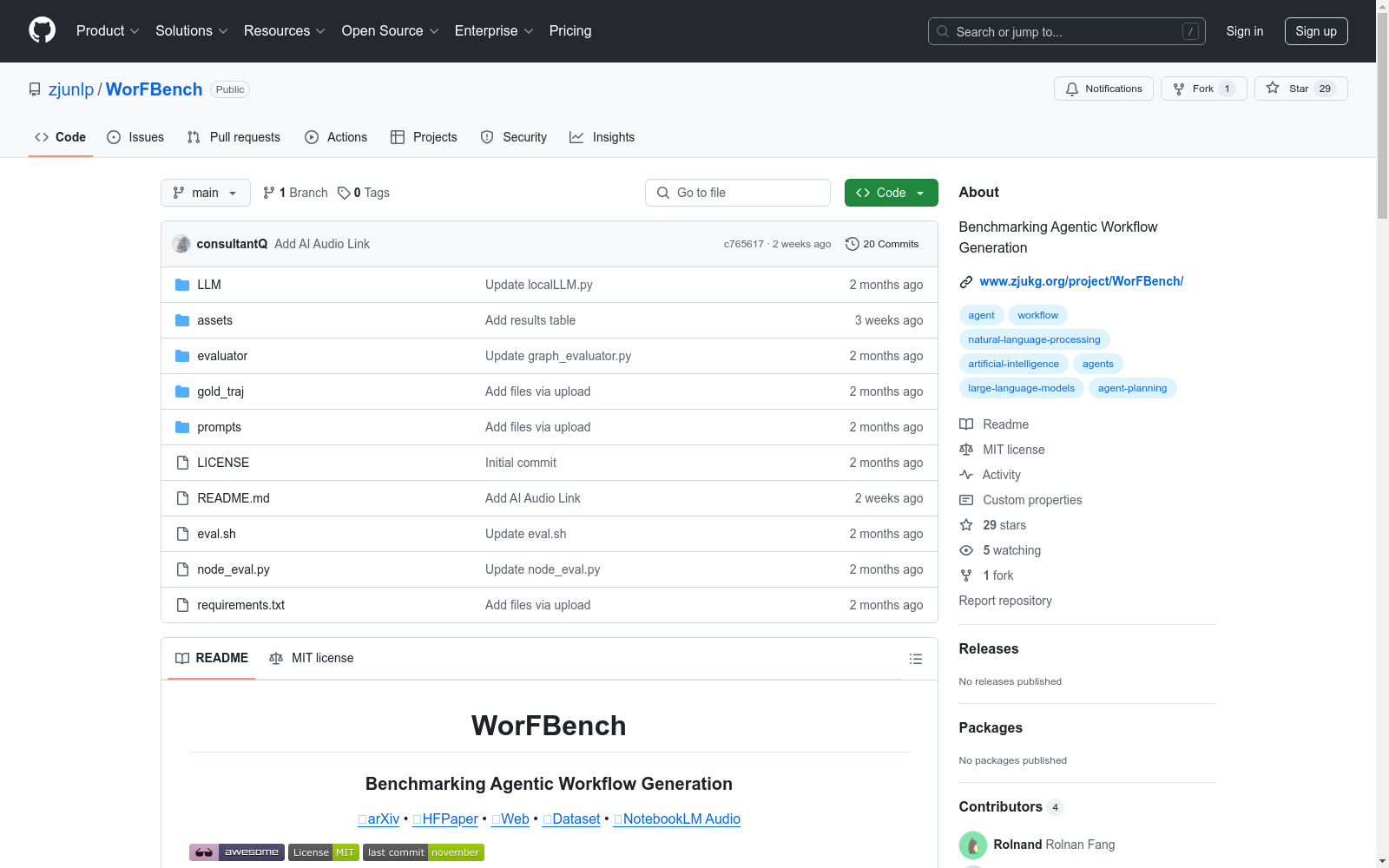

资源简介:

WORFBENCH是由浙江大学和阿里巴巴集团共同创建的一个统一的工作流生成基准数据集,旨在评估大型语言模型(LLMs)在复杂任务分解中的能力。该数据集涵盖了四个复杂场景,包括问题解决、函数调用、具身规划和开放式规划,包含18k训练样本和2146测试样本。数据集通过严格的质控和数据过滤,确保了工作流图的复杂性和准确性。WORFBENCH的应用领域主要集中在提升LLMs在下游任务中的表现,通过生成高效的工作流图,减少推理时间并提高任务完成效率。

原始地址:

https://github.com/zjunlp/WorFBench