资源简介:

MedTrinity-25M是由华中科技大学、加州大学圣克鲁兹分校、哈佛大学和斯坦福大学联合创建的一个大规模多模态医学数据集,包含超过2500万张图像,涉及10种模态和65种疾病。数据集通过自动化的数据构建流程生成,不依赖于配对的文本描述,而是通过专家模型和知识库增强的多模态大型语言模型生成多粒度视觉和文本注释。数据集的创建过程包括从90多个在线资源收集数据,应用专家模型识别感兴趣区域(ROIs),并构建知识库以生成详细的文本描述。MedTrinity-25M旨在支持广泛的医学多模态任务,如图像标注和报告生成,以及视觉中心的任务如分类和分割,推动医学领域基础模型的发展。

原始地址:

https://yunfeixie233.github.io/MedTrinity-25M/

提供机构:

华中科技大学, 加州大学圣克鲁兹分校, 哈佛大学, 斯坦福大学

MedTrinity-25M 数据集概述

数据集名称

MedTrinity-25M: A Large-scale Multimodal Dataset with Multigranular Annotations for Medicine

作者信息

- Yunfei Xie<sup>1,*</sup>

- Ce Zhou<sup>1,*</sup>

- Lang Gao<sup>1,*</sup>

- Juncheng Wu<sup>2,*</sup>

- Xianhang Li<sup>2</sup>

- Hong-Yu Zhou<sup>3</sup>

- Sheng Liu<sup>4</sup>

- Lei Xing<sup>4</sup>

- James Zou<sup>4</sup>

- Cihang Xie<sup>2</sup>

- Yuyin Zhou<sup>2</sup>

机构信息

- <sup>1</sup> Huazhong University of Science and Technology

- <sup>2</sup> UC Santa Cruz

- <sup>3</sup> Harvard University

- <sup>4</sup> Stanford University

数据集链接

数据集简介

MedTrinity-25M 是一个大规模的多模态医学数据集,涵盖超过2500万张图像,涉及10种不同的医学成像模态,并对超过65种疾病进行了多粒度标注。这些丰富的标注包括全局文本信息(如疾病/病变类型、模态、区域特定描述和区域间关系)以及感兴趣区域(ROI)的详细局部标注(如边界框、分割掩码)。与现有方法不同,该数据集通过自动化的流水线生成多粒度的视觉和文本标注(以图像-ROI-描述三元组的形式),无需任何配对的文本描述。具体来说,从90多个不同来源收集、预处理和定位数据,使用领域特定的专家模型识别与异常区域相关的ROI,然后构建一个全面的知识库,并提示多模态大型语言模型进行检索增强生成,从而生成多粒度的文本描述。与现有数据集相比,MedTrinity-25M提供了最丰富的标注,支持广泛的多模态任务,如标题生成和报告生成,以及以视觉为中心的任务,如分类和分割。该数据集可用于支持多模态医学AI模型的大规模预训练,有助于未来医学领域基础模型的发展。

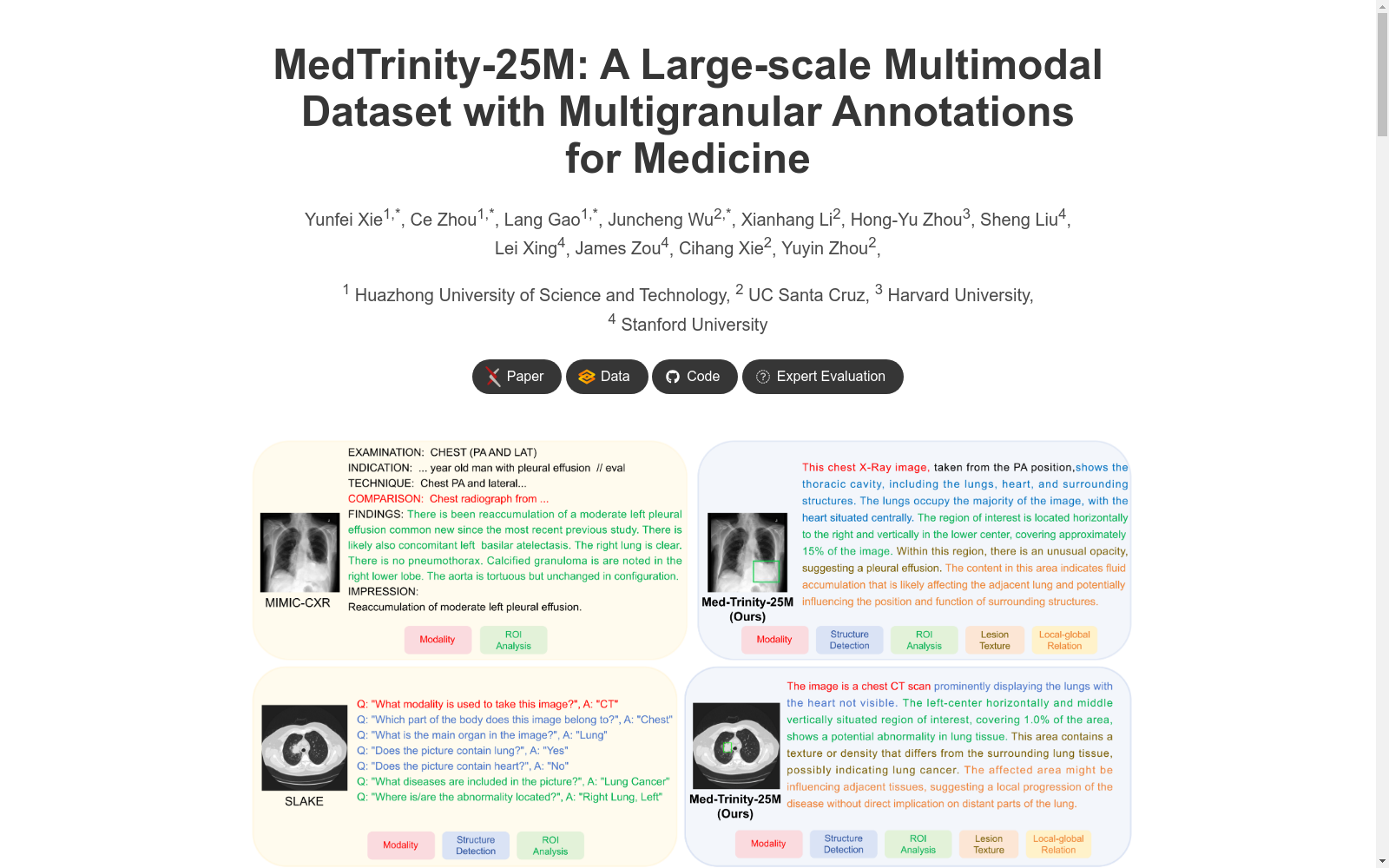

数据集示例

数据集示例图像展示了多粒度的文本描述,其属性比现有的胸部X射线数据集MIMIC-CXR、视觉QA数据集SLAKE和放射学对象标题数据集ROCO更为丰富。

数据集可用性

数据集公开可用,链接为 MedTrinity-25M