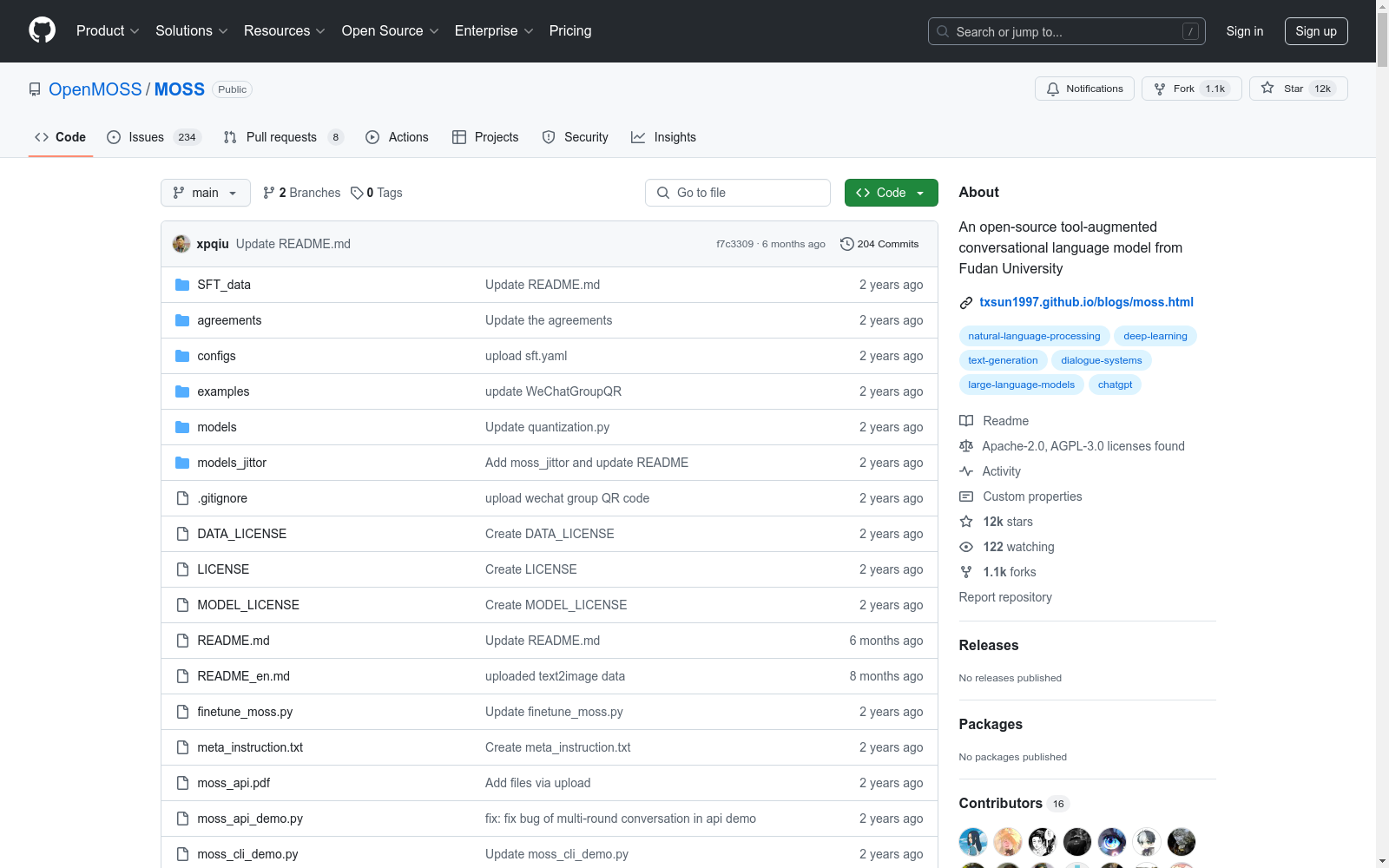

MOSS 是一个支持中英双语和多种插件的开源对话语言模型,具有160亿参数。该模型在约七千亿中英文以及代码单词上预训练得到,后续经过对话指令微调、插件增强学习和人类偏好训练,具备多轮对话能力及使用多种插件的能力。

moss-moon-003-sft模型。moss-moon-003-sft模型。moss-moon-003-sft-plugin模型。moss-moon-003-sft-plugin模型。moss-moon-003-sft所使用的多轮对话数据,约含110万条对话数据。moss-moon-003-sft-plugin所使用的插件增强的多轮对话数据,包含约30万条多轮对话数据。moss-moon-003-pm、moss-moon-003和moss-moon-003-plugin模型。moss-003-pm-data数据。