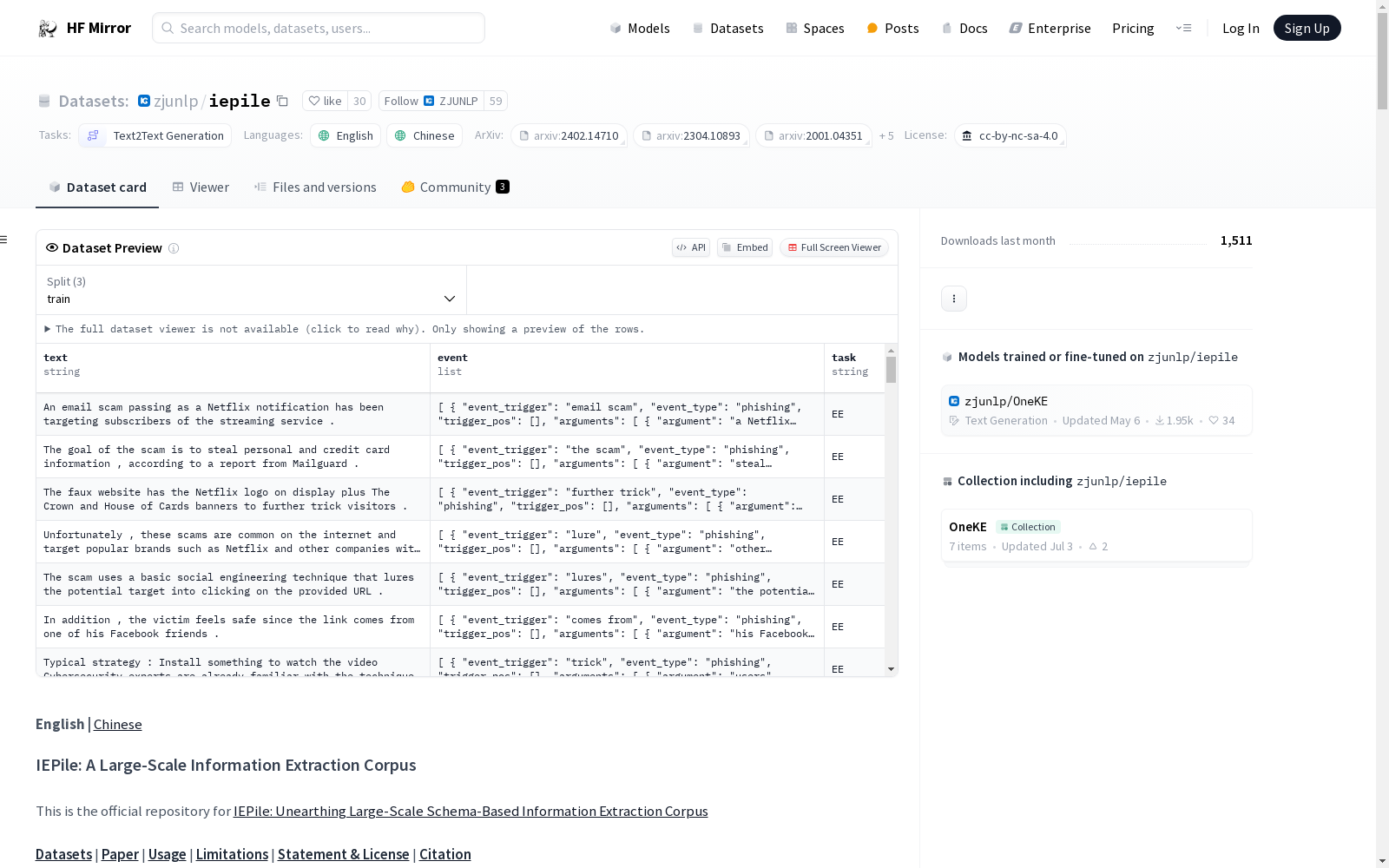

IEPile: A Large-Scale Information Extraction Corpus

IEPile是一个大规模的信息提取数据集,专注于基于schema的指令生成方法。该数据集整合了26个英文和7个中文信息提取(IE)数据集,覆盖多个领域,如通用、医疗、金融等。

task, source, instruction, output。其中instruction采用JSON-like字符串结构,包含instruction, schema, input三个主要组件。数据集遵循CC BY-NC-SA 4.0许可协议。

若使用IEPile或相关代码,请引用以下文献:

@article{DBLP:journals/corr/abs-2402.14710, author = {Honghao Gui and Lin Yuan and Hongbin Ye and Ningyu Zhang and Mengshu Sun and Lei Liang and Huajun Chen}, title = {IEPile: Unearthing Large-Scale Schema-Based Information Extraction Corpus}, journal = {CoRR}, volume = {abs/2402.14710}, year = {2024}, url = {https://doi.org/10.48550/arXiv.2402.14710}, doi = {10.48550/ARXIV.2402.14710}, eprinttype = {arXiv}, eprint = {2402.14710}, timestamp = {Tue, 09 Apr 2024 07:32:43 +0200}, biburl = {https://dblp.org/rec/journals/corr/abs-2402-14710.bib}, bibsource = {dblp computer science bibliography, https://dblp.org} }