资源简介:

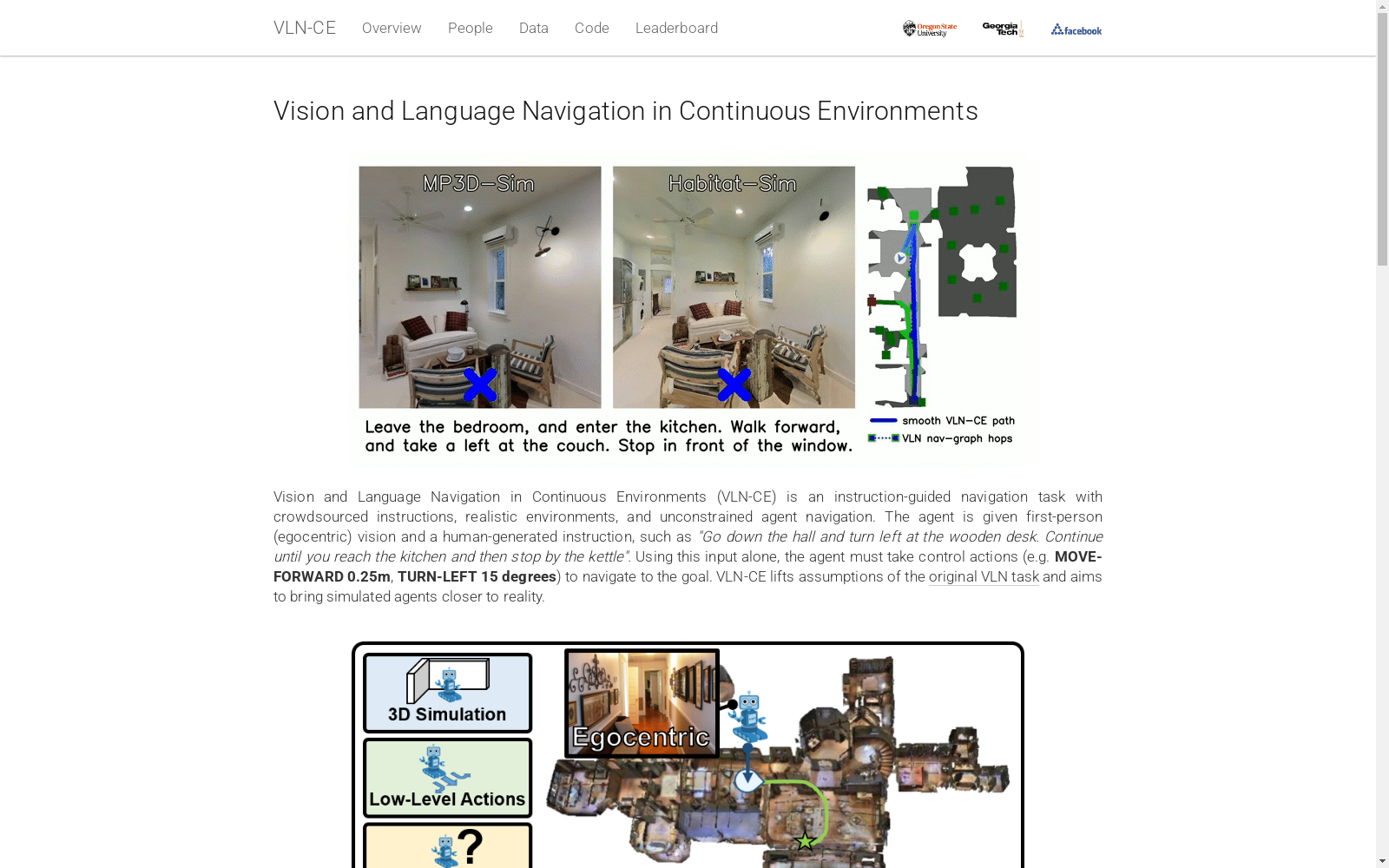

VLN-CE 数据集由 Oregon State University 和 Georgia Institute of Technology 等机构联合开发,旨在推动视觉与语言导航任务从离散导航图向连续环境的转变。该数据集基于 Matterport3D 环境构建,包含 4475 条从 Room-to-Room 数据集转换而来的导航轨迹,每条轨迹配备多条自然语言指令和低级动作序列。数据集规模可观,平均轨迹长度达 55.88 步,远超传统导航图任务。其创建过程涉及将离散导航图中的全景节点映射到连续 3D 环境,并通过 A* 搜索算法验证路径可行性。VLN-CE 数据集主要用于研究机器人在真实世界中的语言指令跟随能力,解决传统导航图假设过多导致的性能虚高问题,为机器人导航与人机交互研究提供更贴近现实的测试平台。

原始地址:

https://jacobkrantz.github.io/vlnce/

提供机构:

Oregon State University et al.